一个MeDIP-seq实战-超级简单-2小时搞定!

Featured

MeDIP-seq 跟ChIP-seq的分析手段是一模一样的,同理hMeDIP-seq,caMeDIP-seq等等,都没有本质上的区别,只是用的抗体不一样而已,请自行搜索基础知识,我只讲数据分析。

一个RNA-seq实战-超级简单-2小时搞定!

scalpel软件找indel

Scalpel is available here: http://scalpel.sourceforge.net/

文章是: http://www.nature.com/nmeth/journal/v11/n10/full/nmeth.3069.html

很赞的工具!

软件说明书写的也比较详细:http://scalpel.sourceforge.net/manual.html

他提供了3种情况的找INDELs变异,我目前需要用的就是对我的全基因组测序数据来找,所以用single模式:

为了节省对计算资源的消耗,作者建议我单独对每条染色体分别处理。 Continue reading

不要想当然的使用生信软件,读文档,勤搜索!

最近在写一篇很有趣的文章,一张图说清楚wgs,wes,rna-seq,chip-seq的异同点!

需要用到一些测试数据,我准备拿17号染色体的40437407-40486397这约48Kb碱基区域来举例子,就需要把这个区域的bam提取出来。

我分别找了以前处理的wgs,wes,rna-seq,chip-seq公共数据,原始bam非常大,尤其是WGS的,45G的bam文件,所以只能抽取17号染色体的40437407-40486397这约48Kb碱基区域,以前我做mpileup或者其它都是用的-r 参数,所以我想当然的使用下面的代码: Continue reading

用谷歌搜索来使用ggplot2做可视化(下)

用谷歌搜索来使用ggplot2做可视化(下)

我知道会有续集,但也没想到续集来得这么快!今天收到了一个生信技能树公众账号铁杆粉丝(我们之间有过9次邮件交流)的求助信,下面我们首先一起帮他解决一下碰到的问题。随后和大家分享一下可以提高搜索效率和准确率的Google搜索技巧。

如何通过Google来使用ggplot2可视化(上)

如何通过Google来使用ggplot2可视化

今天是大年初二,这篇文章我只想传达一点:

没有什么菜鸟级别的生物信息学数据处理是不能通过Google得到解决方案的,如果有,请换个关键词继续Google!

第一部分

首先用两分钟的时间简单介绍一下R语言:

因为这个语言是肉丝儿(Ross Ihaka)和萝卜特(Robert Gentleman)两个人1992年在S语言的基础上发明出来的开源语言,所以叫做R语言。这两个人是统计学教授出身,所以R语言在统计学方面有着纯正的血统!如果你平时的工作和统计相关,你好意思不会点R语言么?

一个标准的TCGA大文章应该做哪些数据?

给初学者的忠告,不要拿一套垃圾数据入门!

垃圾数据对初学者的伤害真的很可怕!

最近在带一些朋友入门,想起了当年自己入门的各种凄惨惨戚戚!

碱基质量值很差,GC不平衡,还有接头,PCR重复也很多,kmer值也很诡异,时间都耗在QC上面了,结果几个月下来,你一个流程都没搞明白,各种查资料,还是在原地打转。 Continue reading

测序深度和GC含量的问题!【直播】我的基因组 47

在前面我们提到了用ChIP-seq的分析方法可视化了一下我的WGS数据,结果我们的测序深度分布居然是跟基因组的genomic feature相关的~~~

比如在TSS附近,就很明显看到了一个测序深度峰值,那么前面我们并没有给出直接的解答,而且简单的提了一下这是二代测序的特点,GC含量片段偏好性!

作为一个合格的生物信息学工程师,我当然要把这个理论用自己的代码和数据来亲身实践一遍~

我首先把全基因组的bam文件用mpileup模式输出,根据1000bp的窗口滑动来统计每个窗口的测到的碱基数,GC碱基数,测序总深度!

代码比较复杂,一般人可能理解不来的!

我是如何学习WGCNA分析

首先声明,我不会WGCNA分析,只是大概知道它会对大量样本(>8或者15)的表达矩阵进行统计学分析,然后把表达矩阵的基因找到一下基因集合,有一些基因集合大概是非常有意义的!

因为有朋友一直好奇,我是如何学习新的知识的,所以就趁这个机会,录制了3个视频,只是我的一个学习过程而已。感兴趣可以去链接:http://pan.baidu.com/s/1jIgBTzw 密码:yh42下载,但是最后一个视频录制过程中被打断了,所以我只好重新写了个文字版的,来补充解释一下。(如果你看视频,请先看那个必看!)

学习一个新的概念,新的分析方法,我首先是谷歌了一下这个关键词,找到两个非常赞的链接!

就是拿到表达矩阵,根据MAD来挑选top5000个基因的表达矩阵,然后用WGCNA的包构建共表达网络,检测每一个module是什么,有什么特性。接着把这些module跟个体结合起来。

一个RNA-seq的反思

备忘录- Universal Human Reference RNA sample (HUR)-样本列表

大家不要点击,我把这个博客当做笔记本的,这个知识点对你们几乎木有用的!

Universal Human Reference RNA 似乎是agilent公司的,包含了10个不同的人类细胞系!roadmap对这些样本测了RNA-seq,我以后课题可能会用得着。

列表如下: Continue reading

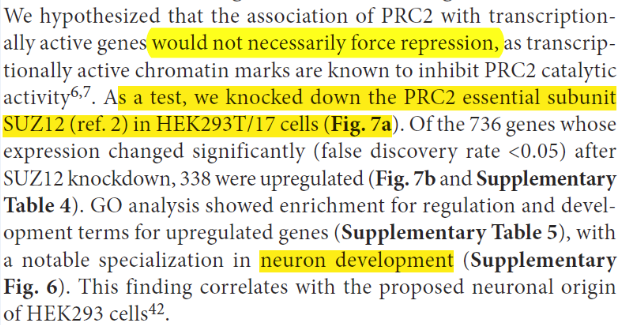

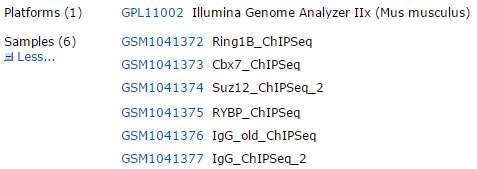

CBX7在ESC里面重要作用发现史

一个ChIP-seq实战-超级简单-2小时搞定!

ngsplot辅助CHIP-seq数据分析-可视化

一个RNA-seq实战-超级简单-2小时搞定!

生信分析人员如何系统入门python?

生信分析人员如何系统入门R?

生信分析人员如何系统入门perl?

生信分析人员如何系统入门linux?

我作为老一辈的生信工程师,所以喜欢perl一点,排斥python,其实呢,我也稍微看过一些python的语法,个人认为R和python几乎是一模一样的。R的特点就是内置了大量的函数,基本上你认识的英文单词都可以是一个函数,即使不是,你也可以自定义为函数。搞清楚了函数和变量,就可以看懂大部分的R代码了。

下面是生信菜鸟团QQ群管理员赵云对这3种编程语言的心得体会!

生物信息数据分析文章就是看图写作文

TCGA表达数据的多项应用之4–求指定基因在指定癌症里面的表达量相关性矩阵,与所有的基因比较。

这个不出图,会给出TCGA里面涉及到的所有基因跟你指定的基因的表达量相关系数和P值,分别你一次性的看清楚你感兴趣的基因跟体内其它基因在该癌症种类的相关性,当然,相关非因果,请谨慎应用! Continue reading